-

Keras 지원하는 활성함수(2)카테고리 없음 2019. 11. 26. 00:17

4) LeakyRelu

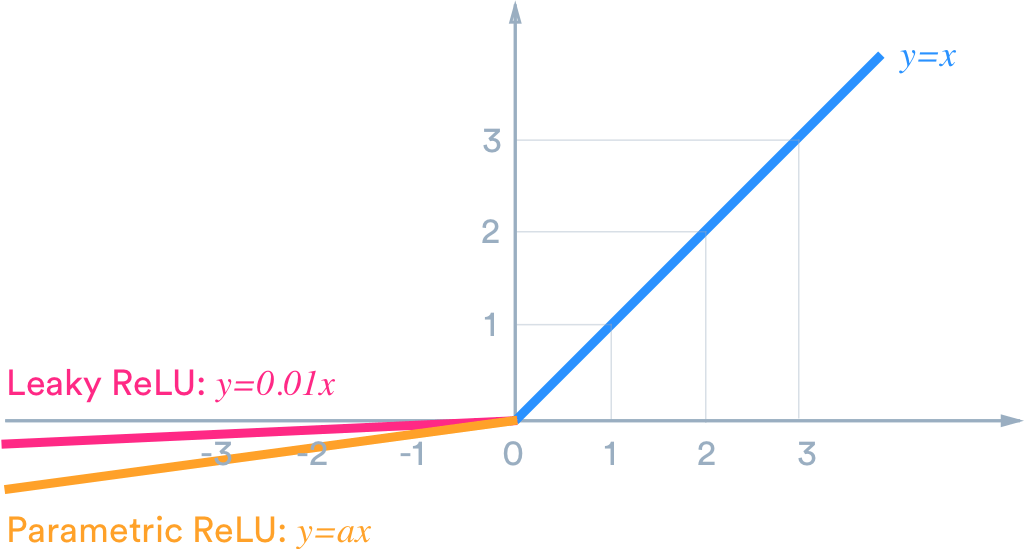

이전 포스팅에서 다루었던 활성함수 중 Relu는 x < 0 일때, 0 값을 가지는 단점을 가진다. 따라서 음수 값에 대한 정보를 사용할 수 없다는 한계점을 가진다.

그림 출처: https://medium.com/@himanshuxd/activation-functions-sigmoid-relu-leaky-relu-and-softmax-basics-for-neural-networks-and-deep-8d9c70eed91e 위 그림과 같은 형태로 Leaky Relu는 x < 0 일 때도 값을 가지면 Alpha 값을 이용하여 기울기를 조정 할 수 있다.

Keras 사용 예

LeakyReLU(alpha=0.3)

5) ELU

ELU도 동일하게 Relu가 x < 0 일 때 0 값이 되는 문제점을 해결하기 위해서 사용되어진다. ELU는 x가 음수 값을 가질 때 지수 형태 y = α( ex – 1) 값을 가진다.

그림 출처: https://sefiks.com/2018/01/02/elu-as-a-neural-networks-activation-function/ ELU도 동일하게 Alpha 값을 이용하여 꺽이는 정도를 조절 할 수 있다.

Keras 사용 예

LU(alpha=0.1)